Przetrwanie jakościowego dziennikarstwa wymaga uniezależnienia się od cybergigantów. Unijne regulacje to ważny krok w tę stronę, ale tak długo jak media pozostaną „na łasce” algorytmów wielkich platform i wyszukiwarek, trudno będzie im odzyskać utracone na ich rzecz wpływy.

- Pakiet regulacyjny składający się z Aktu o usługach cyfrowych (Digital Services Act – dalej: DSA) oraz Aktu o rynkach cyfrowych (Digital Markets Act – dalej: DMA) ma być przede wszystkim odpowiedzią na dominację wielkich platform w sferze cyfrowej, choć wprowadza także nowe prawa i obowiązki dla innych usługodawców świadczących tzw. usługi pośrednie w sieci („pośredników internetowych”), w tym regulacje, które mogą być szczególnie istotne z punktu widzenia sektora medialnego.

- DSA zawiera regulacje dotyczące różnych aspektów działalności pośredników internetowych, związane przede wszystkim z rolą, jaką podmioty te odgrywają w zakresie dystrybucji informacji w sieci, nakładając jednocześnie na nie szereg nowych obowiązków. Rozporządzenie dotyczy wszystkich tego typu usługodawców cyfrowych, którzy świadczą swoje usługi w UE, niezależnie od miejsca ich siedziby (a więc także tych spoza Europy).

- DMA, czyli druga noga reformy rynku usług cyfrowych, ma uzupełniający charakter wobec DSA i reguluje odpowiedzialność wybranej kategorii pośredników internetowych, o dominującej pozycji rynkowej, określanych jako „strażnicy dostępu” (ang. gatekeepers). Dotyczy zatem platform, które w praktyce mają największy wpływ na to, jak wygląda nasza cyfrowa rzeczywistość.

- Czy nowy pakiet regulacyjny wzmocni pozycję profesjonalnych mediów względem wielkich platform i pozwoli im się wreszcie wyrwać z cyfrowego klinczu? Media, podobnie jak inni użytkownicy, staną się niewątpliwie beneficjentami wszystkich tych postanowień DSA i DMA, które zwiększają np. gwarancje przejrzystości moderacji treści, systemów rekomendacyjnych czy ochronę interesów mniejszych usługodawców. Ale rewolucji raczej nie będzie.

- Dla losów całej branży mediów najbardziej kluczowe wydają się jednak postanowienia DSA-DMA odnoszące się nie tyle do nich samych, ile do największych platform internetowych i wyszukiwarek. Rosnące znaczenie platform w komunikacji internetowej, w tym dla dostępu do newsów, stało się nie tylko źródłem nowych wyzwań prawnych w wielu obszarach związanych z obiegiem informacji w sieci, ale także napięć pomiędzy sektorem big tech a „tradycyjnymi” mediami.

Publikujemy analizę projektu Oczyszczalnia, przygotowaną przez ekspertkę Fundacji Panoptykon Dorotę Głowacką na temat pakietu europejskiej pakietu regulacyjnego Digital Services Act i Digital Markets Act.

Wprowadzenie – w stronę nowego ładu cyfrowego w UE

W 2000 r. Unia Europejska przyjęła tzw. dyrektywę o handlu elektronicznym[1]. Nazwa może wydawać się myląca, sugerując, że chodzi o regulację sprzedaży towarów w sieci. W rzeczywistości stawka jest dużo wyższa. Zawarte w dyrektywie zasady wyznaczają warunki współczesnego obiegu informacji w sieci, a także status podmiotów, które w praktyce kontrolują to, co i kiedy możemy zobaczyć lub powiedzieć online. Dotyczy to również największych globalnych cyberkorporacji, które zbudowały swoją potęgę m.in. dzięki przyjętym w dyrektywie założeniom – sprzyjającym rozwojowi oferowanych przez nie usług, ale niekoniecznie odpowiedzialności za wywoływane „przy okazji” szkody.

Dyrektywa powstała w czasach, w których nie istniały jeszcze Facebook, YouTube czy iPhone. Nie odnosi się więc do realiów współczesnego rynku cyfrowego, które charakteryzują zarówno szanse, jak i wyzwania związane przede wszystkim z rozkwitem największych platform internetowych i internetu mobilnego. Dwie dekady od przyjęcia dyrektywy o handlu elektronicznym najpopularniejsze serwisy społecznościowe i wyszukiwarki odgrywają kluczową rolę w realizacji swobody wypowiedzi i wielu innych praw podstawowych.

Rola ta została już wielokrotnie dostrzeżona zarówno w „miękkim prawie” międzynarodowym[2], jak i w orzecznictwie europejskich trybunałów[3]. Jednocześnie jednak piętrzą się dowody na to, że działalność cyfrowych gigantów wywołuje szereg niekorzystnych skutków i zagrożeń, nie tylko w sferze praw użytkowników, ale też w obszarze uczciwej konkurencji, funkcjonowania sektora medialnego czy demokracji. Wysiłki badaczy, dziennikarzy śledczych, aktywistów praw cyfrowych, a także sygnalistek, takich jak Frances Haugen, rzuciły więcej światła na niepokojące praktyki dużych firm internetowych i ich szkodliwe konsekwencje dla ochrony prawa do prywatności, zdrowia psychicznego, dostępu do wiarygodnych i jakościowych informacji czy integralności procesów wyborczych[4]. W doniesieniach tych ujawniono m.in., że działalność dużych platform może przyczyniać się do nasilenia dyskryminacji, manipulacji wykorzystującej ludzkie słabości, szerszej dystrybucji nienawistnych, toksycznych treści i dezinformacji czy radykalizacji poglądów oraz pogłębiania polaryzacji społecznej.

Za źródło tych problemów coraz bardziej powszechnie uznaje się model biznesowy, w oparciu o który funkcjonują wielkie platformy, trafnie określony przez harwardzką ekonomistkę Shoshanę Zuboff mianem „kapitalizmu inwigilacji”[5]. W model ten wpisane jest instrumentalne przetwarzanie danych osobowych użytkowników na szeroką skalę, pozyskanych również na podstawie analizy i wyciągania wniosków z ich zachowania w sieci (także poza daną platformą). Odbywa się to często bez pełnej świadomości i wiedzy użytkowników na temat przebiegu tego procesu. Pozyskane w ten sposób informacje są wykorzystywane przez algorytmy platform m.in. do personalizowania wyświetlanych odbiorcom treści, które są zoptymalizowane na generowanie jak największego „zaangażowania” i maksymalizację czasu spędzanego przed ekranem, bez względu na wiarygodność informacji, ich realny wkład w debatę publiczną czy ewentualną ingerencję w prawa i dobrostan użytkowników.

Po latach negocjowania „miękkich” rozwiązań samoregulacyjnych[6] z dużymi platformami internetowymi przez instytucje UE, które miały skłonić je do dobrowolnej reakcji na powyższe problemy, można obecnie zaobserwować zwrot w kierunku wprowadzenia „twardych” regulacji prawnych. Ich nadrzędnym celem jest zwiększenie zakresu odpowiedzialności platform, wzmocnienie pozycji użytkowników korzystających z ich usług, a także zagwarantowanie większej równowagi i warunków uczciwej konkurencji na rynku cyfrowym, który dziś zdominowała garstka cybergigantów. Na marginesie należy dodać, że podobny trend można zaobserwować również na poziomie poszczególnych krajów członkowskich UE[7], także w Polsce[8].

Najbardziej kompleksową propozycją reformy w tym obszarze jest przyjęty w 2022 r.[9] pakiet regulacyjny składający się z Aktu o usługach cyfrowych (Digital Services Act – dalej: DSA) oraz Aktu o rynkach cyfrowych (Digital Markets Act – dalej: DMA), który uzupełni, a częściowo zastąpi, postanowienia dyrektywy o handlu elektronicznym. Choć regulacje te mają być przede wszystkim odpowiedzią na dominację wielkich platform w sferze cyfrowej, warto podkreślić, że wprowadzają także nowe prawa i obowiązki dla innych usługodawców świadczących tzw. usługi pośrednie w sieci[10] („pośredników internetowych”), w tym regulacje, które mogą być szczególnie istotne z punktu widzenia sektora medialnego. W odniesieniu do największych firm technologicznych nowe prawo zacznie obowiązywać prawdopodobnie w pierwszej części 2023 r., a wobec pozostałych pośredników na początku 2024 r.[11].

W niniejszym opracowaniu w pierwszej kolejności (pkt. 2 i 3) zarysowane zostaną ogólna charakterystyka i najważniejsze elementy DSA i DMA, ze szczególnym uwzględnieniem tych zagadnień, które w ocenie autorki mogą mieć najbardziej istotny wpływ na funkcjonowanie profesjonalnych mediów i dziennikarstwa w sieci. W dalszej części znajdzie się bardziej szczegółowa analiza wyzwań, z jakimi mierzy się sektor medialny na rynku cyfrowym, zwłaszcza w kontekście (skomplikowanych) relacji z wielkimi platformami (pkt. 4). Wreszcie autorka spróbuje ocenić, na ile rozwiązania zawarte w zaproponowanym pakiecie regulacyjnym mogą stanowić odpowiedź na wspomniane wyzwania rynku medialnego i doprowadzić do wzmocnienia pozycji mediów i jakościowego dziennikarstwa (pkt 5).

DSA – nowe obowiązki pośredników internetowych, większa kontrola użytkowników nad algorytmami

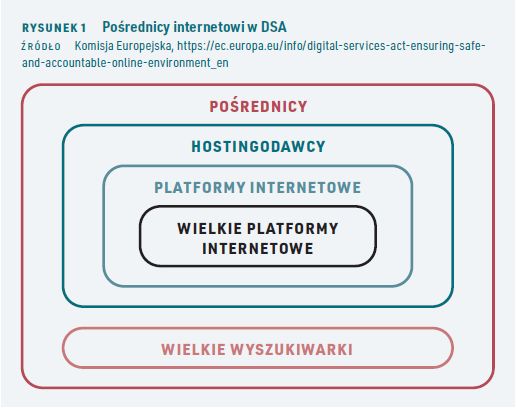

DSA[12] zawiera regulacje dotyczące różnych aspektów działalności pośredników internetowych, związane przede wszystkim z rolą, jaką podmioty te odgrywają w zakresie dystrybucji informacji w sieci, nakładając jednocześnie na nie szereg nowych obowiązków. Rozporządzenie dotyczy wszystkich tego typu usługodawców cyfrowych, którzy świadczą swoje usługi w UE, niezależnie od miejsca ich siedziby (a więc także tych spoza Europy). Na samym wstępnie warto wyjaśnić jednak, że nie wszystkie przewidziane w DSA obowiązki mają zastosowanie do wszystkich rodzajów pośredników – ich zakres jest uzależniony od wielkości i charakteru świadczonych przez nich usług i w założeniu ma korelować ze skalą ryzyk i charakterystyką zagrożeń generowanych przez dany typ działalności (zob. rys. 1 i 2). Nad „bazowymi” zasadami przewidzianymi dla każdego dostawcy usług pośrednich, „nadbudowano” zatem dodatkowe, szczególne reguły dla kolejnych, coraz węższych ich „podkategorii”.

Należą do nich w pierwszej kolejności „hostingodawcy”[13], następnie „platformy internetowe”[14] (ale tylko te, których działalność opiera się na treściach dodawanych przez użytkowników; z zakresu DSA wyłączone są więc np. platformy VOD[15]) i wreszcie „bardzo duże platformy internetowe” (very large online platforms – „VLOPs”), posiadające co najmniej 45 mln użytkowników w UE miesięcznie (co odpowiada ok. 10 proc. populacji Unii). Na ostatniej prostej prac legislacyjnych wyróżniono jeszcze jeden rodzaj podmiotów – „wielkie wyszukiwarki” (very large search engines – „VLOSEs”), tj. wyszukiwarki, których usługi mają zasięg podobny do VLOPs. Dla tych ostatnich dwóch kategorii – VLOPs i VLOSEs – przewidziano najdalej idące obowiązki. Jednocześnie z dodatkowych wymogów przewidzianych dla „platform” zwolniono najmniejszych przedsiębiorców oferujących ten typ usługi[16].

Profesjonalne media nie są więc bezpośrednim adresatem postanowień DSA w zakresie swojej głównej działalności, polegającej na przygotowywaniu i redagowaniu materiałów dziennikarskich. Rozporządzenie ma jednak duże znaczenie dla tego sektora w zakresie, w jakim wydawcy portali informacyjnych pełnią jednocześnie rolę hostingodawców w stosunku np. do komentarzy dodawanych przez użytkowników pod artykułami dziennikarskimi. Warto przy tym zaznaczyć, że DSA wprost wyjaśnia, że utrzymywanie „sekcji komentarzy” nie kwalifikuje takich portali jako „platform”[17]. Z perspektywy branży medialnej istotne znaczenie mają jednak również przepisy DSA skierowane do platform internetowych (w szczególności najpopularniejszych mediów społecznościowych, takich jak Facebook czy YouTube, należących do kategorii VLOPs) oraz wielkich wyszukiwarek (Google), z uwagi na znaczący wpływ tych podmiotów na współczesne funkcjonowanie profesjonalnych mediów i przepływ informacji w sieci (zob. więcej na ten temat w pkt. 4).

DSA reguluje przede wszystkim takie zagadnienia, jak zasady odpowiedzialności hostingodawców za bezprawne treści dodawane przez użytkowników[18], współpraca tych podmiotów z organami państwowymi w zakresie zwalczania tego rodzaju materiałów i inne kwestie związane z tzw. moderacją treści (m.in. obowiązek uzasadniania decyzji moderacyjnych, wymogi odnoszące się do wewnętrznych regulaminów określających kryteria ich podejmowania, obowiązek publikowania cyklicznych sprawozdań przedstawiających zbiorcze dane na ich temat[19]). Niektóre z tych elementów mają całkowicie nowy charakter, inne powielają lub doprecyzowują założenia znane już z dyrektywy o handlu elektronicznym. Dotyczy to w szczególności utrzymania w DSA reżimu warunkowego wyłączenia odpowiedzialności za bezprawne treści dodawane przez osoby trzecie. Hostingodawca nadal nie będzie za nie odpowiadał tak długo, jak nie ma „pozytywnej wiedzy” o ich bezprawnym charakterze, a w momencie jej pozyskania, wciąż może zwolnić się z odpowiedzialności, jeśli niezwłocznie uniemożliwi do nich dostęp (np. usunie je z serwisu). Drugą kluczową zasadą, którą zachowuje DSA, jest zakaz nakładania na pośredników obowiązku ogólnego monitorowania przechowywanych treści. W praktyce oznacza on, że usługodawca co do zasady nie jest zobligowany np. do proaktywnej oceny legalności wszystkich treści publikowanych przez użytkowników.

W DSA doprecyzowano ponadto niektóre kwestie, które na gruncie dyrektywy o handlu elektronicznym budziły istotne wątpliwości interpretacyjne[20], dotychczas rozstrzygane często dopiero w orzecznictwie sądów (które jednak niekiedy dawały sprzeczne odpowiedzi[21]). Uszczegółowiono zwłaszcza procedurę informowania hostingodawcy o bezprawnym charakterze przechowywanej treści (np. przez poszkodowaną osobę) i zasad jego reakcji na takie zawiadomienie (tzw. procedura notice & action) (zob. tabela 1). Wprowadzono także wprost tzw. zasadę dobrego Samarytanina, przewidującą że podejmowanie dobrowolnych działań służących ochronie użytkowników przed nielegalnymi treściami, nie będzie przesłanką negatywnie wpływającą na ewentualną odpowiedzialność usługodawców. W świetle tej zasady portal informacyjny, który w dobrej wierze stara się odfiltrowywać bezprawne komentarze, nie powinien z tego powodu stracić możliwości skorzystania ze zwolnienia z odpowiedzialności za treści dodawane przez czytelników na opisanych wyżej zasadach. Zmiany te częściowo odpowiadają na najczęściej pojawiające się niejasności dotyczące warunków korzystania przez hostingodawców z wyłączenia odpowiedzialności, ale trzeba podkreślić, że nie usuwają wszystkich wątpliwości[22].

Tabela 1. Kluczowe obowiązki hostingodawców w ramach procedury notice & action w DSA

- zapewnienie w serwisie jasnego i łatwo dostępnego mechanizmu, za pomocą którego użytkownik może zawiadomić hostingodawcę o bezprawnym charakterze treści (DSA określa ponadto szczegółowe warunki, które powinno spełniać takie zawiadomienie i wprowadza zasadę, że ich spełnienie powoduje powstanie „pozytywnej wiedzy” o naruszeniu);

- wymóg potwierdzenia otrzymania ww. zawiadomienia, gdy istnieje możliwość kontaktu mailowego z zawiadamiającym;

- poinformowanie zawiadamiającego o podjętej decyzji ws. zawiadomienia, a także udzielenie informacji o ewentualnym wykorzystaniu automatycznych narzędzi w procesie rozpatrywania zawiadomienia;

- poinformowanie użytkownika, który zamieścił sporną treść, o decyzji dotyczącej jej usunięcia wraz z uzasadnieniem (określono także szczegółowo obowiązkowe elementy takiego uzasadnienia) i informacją o dostępnych środkach odwoławczych;

- publikacja ww. decyzji wraz z uzasadnieniem w bazie prowadzonej przez Komisję Europejską.

Platformom internetowym w ocenie treści i bardziej skutecznym zwalczaniu bezprawnych materiałów ma pomóc nowa instytucja „zaufanych podmiotów zawiadamiających” (ang. trusted flaggers). Ich pozycja jest „uprzywilejowana” wobec „zwykłych” użytkowników – na gruncie DSA platformy mają obowiązek priorytetowego traktowania składanych przez nie zawiadomień. Dziś podobna instytucja funkcjonuje w ramach „dobrych praktyk” na niektórych platformach i często rolę tę pełnią np. media, agencje prasowe czy organizacje fact-checkingowe. Teraz status zaufanych podmiotów zawiadamiających został usankcjonowany w prawie. Zgodnie z rozporządzeniem przyznaje go koordynator ds. usług cyfrowych (krajowy organ regulacyjny powołany na mocy DSA), pod warunkiem spełnienia określonych kryteriów. O status zaufanych podmiotów zawiadamiających będą mogły wnioskować podmioty, które wykażą m.in. odpowiednie przygotowanie merytoryczne i niezależność od platform. W toku prac nad DSA zrezygnowano z wymogu zawartego w pierwotnym projekcie rozporządzenia, tj. konieczności reprezentowania przez zaufane podmioty zawiadamiające „interesów grupowych”. Kryterium to krytykował m.in. sektor medialny, obawiając się, że mogłoby ono niezasadnie wykluczyć z możliwości ubiegania się o ten status np. indywidualne redakcje czy agencje informacyjne.

Całkowicie nowym rozwiązaniem, które pojawiło się w DSA, są również gwarancje przed nadmiarowym usuwaniem treści, obejmujące obowiązki w zakresie tzw. standardów sprawiedliwości proceduralnej decyzji moderacyjnych. Zostały one przewidziane przede wszystkim dla platform internetowych. Chodzi głównie o mechanizmy umożliwiające użytkownikom bardziej skuteczne kwestionowanie decyzji o usunięciu wybranego wpisu lub całego konta w serwisie, a także bardziej „miękkie” środki moderacji, takie jak np. ograniczenie widoczności postów czy ograniczenie możliwości zarabiania na publikowanych treściach.

Poza moderacją treści DSA reguluje jeszcze dwa niezwykle ważne obszary z punktu widzenia dystrybucji treści w sieci. Są to zasady dotyczące funkcjonowania reklamy internetowej na platformach internetowych oraz regulacje odnoszące się do tzw. systemów rekomendacyjnych stosowanych przez VLOPs i VLOSEs, które odpowiadają za określony sposób sugerowania, szeregowania i prezentowania poszczególnych materiałów dodawanych przez użytkowników. Oba mechanizmy opierają się często na działaniu algorytmów „zasilanych” danymi użytkowników. DSA przewiduje wprowadzenie minimalnych standardów przejrzystości w tym obszarze. Wszystkie platformy będą miały obowiązek zapewnienia możliwości łatwej identyfikacji danego przekazu jako reklamy, a także udzielenia odbiorcom zindywidualizowanej informacji o tym, w czyim imieniu jest im ona wyświetlana oraz jakie kryteria zadecydowały o pokazaniu im tego konkretnego komunikatu. Dodatkowo bardzo duże platformy będą zobligowane prowadzić publiczną bibliotekę wszystkich reklam, zawierającą m.in. informacje o tym, do ilu osób dotarła dana reklama i jakie kryteria targetowania wybrali reklamodawcy. VLOPs i VLOSEs będą musiały też informować swoich użytkowników o głównych parametrach, które wykorzystują ich systemy rekomendacyjne.

DSA wprowadza ponadto pewne ograniczenia dla wykorzystywania przez platformy danych osobowych użytkowników do celów reklamowych. Jest to odpowiedź na coraz częściej pojawiające się sygnały[23], które wskazują, że w obecnym modelu funkcjonowania platform ta praktyka może prowadzić do inwazyjnego naruszenia praw użytkowników.

Regulacja reklamy internetowej była niewątpliwie jednym z najbardziej kontrowersyjnych punktów w negocjacjach nad DSA. Duża część organizacji zajmujących się ochroną praw cyfrowych postulowała ustanowienie pełnego zakazu tzw. reklamy śledzącej (tj. całkowitego zakazu przetwarzania danych osobowych w ramach systemów reklamowych). Z drugiej strony przeciwko wprowadzeniu takich ograniczeń opowiadały się niektóre środowiska biznesowe. Co oczywiste, protestowało w szczególności lobby wielkich platform[24], ale obawy wyrażała też m.in. branża medialna. Należy podkreślić jednak, że coraz więcej przedsiębiorców rozumie szkodliwość stosowanych obecnie mechanizmów reklamowych, nie chce manipulować klientami ani wykorzystywać ich słabości czy wrażliwych cech i otwiera się na bardziej etyczne oraz szanujące prawa i decyzje użytkowników innowacje w reklamie. Badania wśród małych i średnich przedsiębiorców wskazują m.in., że w większości byliby za wprowadzeniem ograniczeń dla wykorzystywania danych przez największe platformy do celów reklamowych oraz deklarują, że chętnie skorzystaliby z innych form reklamy – gdyby tylko była bardziej dostępna[25]. Istnieją również analizy sugerujące, że reklama kontekstowa (dopasowana do wyświetlanych treści – a nie informacji o oglądającym ją użytkowniku) jest równie, o ile nie bardziej skuteczna[26].

Unijni decydenci przyjęli ostatecznie „pośrednie” rozwiązanie. Nie zgodzili się na całkowity zakaz wykorzystywania danych w celach reklamowych, tym niemniej platformy nie będą mogły profilować reklam, które wykorzystuje niektóre rodzaje danych, tj. dane dzieci i tzw. dane wrażliwe – takie jak informacje na temat stanu zdrowia, poglądów politycznych czy wyznania. Nie oznacza to więc, że wszyscy będziemy oglądać te same reklamy. Targetowanie reklam będzie wciąż dozwolone, ale tylko w oparciu o pozostałe typy danych.

Celem takiego rozwiązania jest właśnie ograniczenie najbardziej inwazyjnych i szkodliwych praktyk reklamowych, które dziś sprzyjają manipulacji i żerowaniu na słabościach użytkowników. W praktyce skuteczność nowej regulacji zależy jednak w dużej mierze od sposobu jej wdrożenia, np. tego, czy platformy w rzeczywistości zrezygnują z mechanizmów pozwalających im na wywnioskowanie wrażliwych cech na podstawie niewrażliwych „danych wejściowych”, pozyskiwanych np. dzięki śledzeniu naszej aktywności w sieci[27]. Istnieją obawy, że w realiach funkcjonowania algorytmów reklamowych wyegzekwowanie tego ograniczenia może być trudne.

W tym kontekście warto wspomnieć jeszcze, że w preambule do DSA przypomniano, że, zgodnie z RODO, personalizacja reklam jest dozwolona jedynie w przypadku użytkowników, którzy wyrażą na to zgodę. W samym rozporządzeniu wprowadzono natomiast dodatkowe gwarancje mające służyć temu, aby platformy nie mogły tej zgody „wyłudzać” czy w inny sposób zakłócać swobodnych decyzji i wyborów użytkowników, stosując np. wprowadzające w błąd interfejsy (tzw. dark patterns).

Jednocześnie w rozporządzeniu nie będzie rewolucyjnych zmian dotyczących regulacji systemów rekomendacyjnych, które dawałyby użytkownikom realną możliwość wpływu na logikę ich funkcjonowania i wybór innego modelu, niż ten, który obecnie dominuje na największych platformach (premiujący wspomniane wcześniej klikalność i zaangażowanie, co przekłada się na większe zasięgi szkodliwych treści, często kosztem wartościowych informacji). VLOPs i VLOSEs zostaną zobligowane jedynie, aby zapewnić użytkownikom opcję wyboru przynajmniej jednego systemu rekomendacyjnego, który nie będzie oparty na profilowaniu (i zamiast tego będzie np. wyświetlać treści chronologicznie), ale z pewnością nie wystarczy to, aby stworzyć skuteczną alternatywę dla domyślnie oferowanych systemów wykorzystujących szeroko zakrojoną analizę danych osobowych i zagwarantować faktyczną kontrolę użytkownika nad własnym strumieniem aktualności. Stracą na tym nie tylko „zwykli” użytkownicy, ale zapewne także media (zob. więcej na ten temat w pkt. 5).

Inne ważne zagadnienie, które reguluje DSA w odniesieniu do największych platform i wyszukiwarek, to dostęp dla odpowiednich organów krajowych i unijnych – a także niezależnych badaczy, w tym z organizacji społecznych – do danych umożliwiających ocenę prawidłowego wywiązywania się z nowych obowiązków. Dodatkowo DSA wprowadzi dla VLOPs i VLOSEs wymogi związane z analizą ryzyk systemowych wynikających z ich funkcjonowania, polegających m.in. na wzmacnianiu rozpowszechniania nielegalnych treści, dezinformacji i innych zagrożeń dla wolności i pluralizmu mediów. W razie stwierdzenia ww. ryzyk rozporządzenie obliguje VLOPs i VLOSEs do wdrożenia środków mających na celu ich redukcję, kładąc nacisk nie tylko na rozliczenie największych platform i wyszukiwarek z dokonanych naruszeń, ale także na systematyczną analizę i zapobieganie potencjalnym negatywnym skutkom. Jednocześnie największe platformy i wyszukiwarki będą miały obowiązek regularnego poddawania się zewnętrznej kontroli w postaci niezależnego audytu.

Wreszcie DSA przewiduje stworzenie nowego instytucjonalnego systemu nadzoru nad prawidłowym wykonywaniem jego postanowień. Składa się on zarówno z organów na szczeblu krajowym (koordynator ds. usług cyfrowych, uprawniony m.in. do rozpatrywania skarg użytkowników dotyczących zgodności działań pośredników z wymogami rozporządzenia), jak i europejskim (Komisja Europejska, uzbrojona w odpowiedni budżet i nowe zespoły ekspertów, m.in. specjalizujących się w audytowaniu algorytmów, oraz Europejska Rada ds. Usług Cyfrowych). Organy te mają stać na straży nowych regulacji lub wspierać ich wdrażanie, a także współpracę transgraniczną w tym obszarze. Rozporządzenie zawiera również możliwość nałożenia wysokich kar za naruszenie przez pośredników ciążących na nich obowiązków w maksymalnej wysokości 6% ich rocznego przychodu lub obrotu.

DMA – czarna lista praktyk „strażników dostępu”

DMA, czyli druga noga reformy rynku usług cyfrowych, ma uzupełniający charakter wobec DSA i reguluje odpowiedzialność wybranej kategorii pośredników internetowych, o dominującej pozycji rynkowej, określanych jako „strażnicy dostępu” (ang. gatekeepers). Dotyczy zatem platform, które w praktyce mają największy wpływ na to, jak wygląda nasza cyfrowa rzeczywistość.

Rozporządzenie[28] określa szczegółowo warunki, których spełnienie przesądza o kwalifikacji danego podmiotu jako „strażnika dostępu”. Przede wszystkim chodzi o usługodawców świadczących określony typ usług (tzw. podstawową usługę platformową), co obejmuje usługi pośrednictwa internetowego, wyszukiwarki internetowe, serwisy społecznościowe, przeglądarki, systemy operacyjne, usługi w chmurze, reklamowe, wirtualnych asystentów, platformy udostępniania wideo oraz usługi łączności interpersonalnej niewykorzystujące numerów (czyli głównie komunikatory internetowe).

Jednocześnie DMA dotyczy tylko usługodawców „wywierających znaczący wpływ na rynek wewnętrzny”, świadczących usługi będącą ważną „bramą” dla użytkowników biznesowych, umożliwiającą dotarcie do użytkowników końcowych oraz posiadających ugruntowaną i trwałą pozycję w zakresie prowadzonej działalności (albo gdy z dużym prawdopodobieństwem można przewidzieć, że taką pozycję osiągną w niedalekiej przyszłości). Przewidziano przy tym konkretne progi ilościowe świadczące o spełnieniu powyższych kryteriów. Odnoszą się one np. do osiąganego rocznego obrotu w Europejskim Obszarze Gospodarczym (co najmniej 6,5 mld euro w każdym z ostatnich trzech lat), wartości kapitalizacji rynkowej (min. 75 mld euro), liczby krajów, w których świadczona jest podstawowa usługa (co najmniej 3 państwa członkowskie) oraz liczby użytkowników (ponad 45 mln aktywnych użytkowników końcowych mających siedzibę lub miejsce pobytu w UE oraz rocznie ponad 10 000 aktywnych użytkowników biznesowych z siedzibą w UE). Z dużym prawdopodobieństwem tak określone kryteria „gatekeepera” spełnia co najmniej wielka czwórka cybergigantów – tzw. „GAFA”, tj. Google, Apple, Facebook i Amazon[29].

W założeniu podstawowym celem DMA jest wspieranie konkurencyjności i równych warunków funkcjonowania różnych podmiotów na rynku cyfrowym oraz ochrona mniejszych usługodawców, a także konsumentów przed szkodliwymi i nieuczciwymi praktykami narzucanymi przez największych graczy. W rozporządzeniu wprowadzono w związku z tym szereg nowych zakazów i obowiązków dla „strażników dostępu” (zob. Tabela nr 2).

Tabela 2. Wybrane obostrzenia dla „strażników dostępu” w DMA:

- zakaz łączenia danych osobowych z różnych serwisów i źródeł oraz zakaz śledzenia użytkowników poza podstawową usługą platformową strażników dostępu do celów reklamowych – bez skutecznej zgody użytkownika (obejmie on np. integrowanie obserwacji na temat użytkowników YouTube’a, wyszukiwarki Google i innych stron internetowych wykorzystujących Google Analytics czy łączenie w jeden profil danych osoby, która korzysta z Facebooka, Instagrama i Whatsappa; daje to realną szansę na ograniczenie głębokości profilowania użytkowników i – w efekcie – może utrudnić pewne niepokojące praktyki, takie jak inwazyjne targetowanie reklam);

- zakaz zmuszania użytkowników do korzystania z różnych usług tej samej platformy (w praktyce może to oznaczać, że telefon z Androidem nie będzie wymagał od użytkownika założenia konta Google);

- zakaz preferowania własnych usług: np. Apple nie będzie mógł nakierowywać użytkowników swoich urządzeń na korzystanie z przeglądarki Safari;

- zakaz wykorzystywania danych użytkowników biznesowych, gdy strażnicy dostępu konkurują z nimi na własnej platformie.

Wybrane obowiązki „strażników dostępu” w DMA:

- wymóg interoperacyjności komunikatorów internetowych (oznacza to bardziej swobodny wybór usług dla użytkowników: mając Signala, nie trzeba będzie być użytkownikiem Messengera, aby rozmawiać z osobami używającymi tego drugiego komunikatora; początkowo będzie to dotyczyć jedynie podstawowych funkcjonalności komunikatorów, ale z czasem ma ulec rozszerzeniu[30])

- obowiązek zapewniania możliwości odinstalowania preinstalowanych aplikacji;

- obowiązek zapewnienia możliwości wykonywania prawa do przenoszenia danych zgodnie z RODO w czasie rzeczywistym;

- obowiązek stosowania niedyskryminujących ogólnych warunków dostępu do sklepów z aplikacjami, wyszukiwarek i mediów społecznościowych dla użytkowników biznesowych;

- obowiązek udostępnienia reklamodawcom i wydawcom ich własnych danych oraz zapewniania stosowanych narzędzi pomiaru wyniku kampanii reklamowych;

- obowiązek informowania Komisji Europejskiej o planowanych przejęciach innych firm.

DMA wprowadza ponadto uprawnienia nadzorcze i śledcze dla Komisji Europejskiej. Komisja ma m.in. mieć prawo identyfikować podmioty spełniające kryteria „strażników dostępu”, przeprowadzać dochodzenia rynkowe, ewentualnie aktualizować listę nałożonych na nie obowiązków i stosować rozmaite „środki zaradcze” oraz nakładać kary za nieprzestrzeganie przepisów rozporządzenia, w tym kary pieniężne m.in. w wysokości do 10 proc. całkowitego rocznego światowego obrotu firmy (bądź do 20 proc., jeśli firma dopuściła się jednego z poważnych nadużyć po raz kolejny). Organy nadzorujące stosowanie DMA będą działać również na szczeblu poszczególnych państw członkowskich, a osoby poszkodowane w wyniku niezgodnego z przepisami działania strażników dostępu będą mogły dochodzić swoich praw przed sądami krajowymi.

W toku prac legislacyjnych Parlament Europejski domagał się, aby użytkownicy (w tym biznesowi) oraz konkurenci byli uprawnieni do złożenia skargi do Komisji Europejskiej (za pośrednictwem organów krajowych) na naruszenie przepisów rozporządzenia przez „strażników dostępu”. Wprowadzenie takiego mechanizmu skargowego niewątpliwie zwiększyłoby szanse na skuteczne egzekwowanie postanowień DMA, i zapewniło podmiotom „poszkodowanym”, w tym z branży medialnej, bezpośrednie narzędzie rozliczenia „strażników dostępu” z obserwowanych nadużyć. Ostatecznie jednak nie przewidziano takiego instrumentu w tekście rozporządzenia. DMA przewiduje jedynie, że użytkownicy będą mogli poinformować Komisję Europejską lub organy krajowe o naruszeniu jego postanowień przez cybergigantów. Nie będzie to jednak formalnie skarga, którą te instytucje będą miały obowiązek się zająć.

Media w cyfrowym klinczu

Niewątpliwie zarówno DSA, jak i DMA będą miały najbardziej znaczący wpływ na funkcjonowanie wielkich platform internetowych, dla których zaprezentowany pakiet regulacyjny wprowadza najdalej idące zmiany. Tym samym jednak oczywiste jest, że wpłynie on również na obieg wiadomości (news) w sieci oraz na sektor medialny. Choć dominujące platformy same nie wytwarzają treści prasowych, to odgrywają dziś bardzo istotną rolę w ich dystrybucji, kontrolując część obszaru, który wcześniej pozostawał w dużej mierze w rękach właścicieli „tradycyjnych” mediów. Kontrola ta sprawia, że wydawcom trudno zrezygnować z obecności na platformach – są poniekąd „zmuszeni” do tego, aby na nich polegać, walcząc o uwagę czytelników. Zależność ta generuje liczne napięcia.

Wzrost znaczenia platform internetowych w dostępie do wiadomości związany jest przede wszystkim z upowszechnieniem smartfonów i mobilnego internetu, co nastąpiło w drugiej dekadzie XXI wieku[31]. Liczne badania potwierdzają, że platformy stały się przestrzenią, z której coraz większa liczba odbiorców (zwłaszcza młodych) czerpie codzienne informacje, w tym dociera za ich pośrednictwem (a nie przez strony źródłowe gazet) do treści publikowanych przez wydawców prasowych.

Trend ten ilustruje m.in. raport Digital News Report 2020. Z zebranych w raporcie danych z 40 krajów na świecie wynika, że tylko nieco ponad jedna czwarta respondentów korzystała ze stron źródłowych mediów lub aplikacji oferowanych przez wydawców jako najczęstszego sposobu dostępu do wiadomości w sieci. Natomiast aż 72 proc. respondentów docierało do nich najczęściej za pośrednictwem: portali społecznościowych (26 proc.), wyszukiwarek (25 proc.) oraz agregatorów wiadomości, „newsletterów” czy „alertów mobilnych”[32]. Według Pew Research Center, w Stanach Zjednoczonych serwisy społecznościowe, jako źródło wiadomości, wyprzedziły w 2018 r. papierowe wydania gazet, a w najmłodszej grupie wiekowej (18-29 lat) także telewizję[33].Wnioski te odpowiadają perspektywie samych właścicieli mediów – badanie przeprowadzone w 2020 r. wśród australijskich wydawców wykazało, że łącznie nawet do 75 proc. ruchu na ich stronach internetowych pochodzi z mediów społecznościowych i wyszukiwarek[34].

Jednocześnie technologia, którą początkowo postrzegano jako potencjalne wzmocnienie zasięgu profesjonalnych mediów w dobie cyfryzacji, okazała się narzędziem leżącym u podstaw ich aktualnego kryzysu. Rozwój platform internetowych nie tylko nie doprowadził do powstania zdemokratyzowanych mediów i lepiej poinformowanego społeczeństwa, ale w ciągu dwóch dekad spowodował szereg niekorzystnych zmian w ekosystemie mediów i dziś bywa uznawany za jedno z największych zagrożeń dla dziennikarstwa wysokiej jakości, działającego w interesie publicznym[35]. Zarzewiem konfliktu obu branż są malejące przychody wydawców z reklam, związane z przejęciem istotnej części rynku reklamowego przez platformy cyfrowe, co wpłynęło na destabilizację ugruntowanego wcześniej modelu ekonomicznego prasy informacyjnej i konieczność poszukiwania nowej formuły biznesowej. Wydawców dodatkowo dotykają takie zjawiska, jak utrata marki (nazwa tytułu prasowego, z którego pochodzą wiadomości konsumowane w mediach społecznościowych, jest rozpoznawana przez mniej niż połowę użytkowników[36]) oraz brak kontroli nad wiedzą o swoich odbiorcach (dane te bowiem w dużej mierze pozyskują i wykorzystują obecnie pośrednicy[37]).

Aspekty ekonomiczne to jednak nie wszystko. Obecnie wydawcy tracą na rzecz platform internetowych nie tylko przychody z reklam, ale przede wszystkim wpływ na kształtowanie opinii publicznej. To dostawcy nowych technologii mają kontrolę nad tym, do jakich informacji odbiorcy ostatecznie mają dostęp, a także coraz większe przełożenie na kształt i jakość samego dziennikarstwa. Jak pisze I. Wolska-Zogata, „niewielka liczba firm [technologicznych] ma znaczną kontrolę nad wolną prasą i obszarami tradycyjnie dziennikarskimi”[38].

Kontrola ta obejmuje w szczególności nieprzejrzysty i arbitralny sposób moderacji treści. W konsekwencji z niejasnych przyczyn i bez możliwości skutecznego odwołania się z mediów społecznościowych usuwane są niekiedy zgodne z prawem wypowiedzi, w tym materiały mające istotne publiczne znaczenie, jak np. relacje z protestów społecznych, fotografie historyczne, publikacje dokumentujące brutalność policji, sztuka czy satyra. Problem ten dotyczy również publikacji dziennikarskich i może znacząco wpływać na możliwość szerokiego rozpowszechniania ich przez wydawców.

Jednym z głośnych przykładów jest usunięcie przez Facebooka postu z profilu norweskiego dziennika „Aftenposten”, zilustrowanego słynną fotografią wykonaną podczas wojny w Wietnamie, która przedstawia nagą, 9-letnią dziewczynkę uciekającą przed zrzutem napalmu (znane jako Napalm girl photo). Facebook uzasadnił blokadę naruszeniem przez gazetę wewnętrznych regulacji dotyczących zakazu prezentowania na portalu nagości. Innym przykładem jest usunięcie na tej samej platformie konta brytyjskiego magazynu satyrycznego „Viz”[39] czy profilu szwedzkiego radia publicznego przez portal Instagram[40]. Warto podkreślić przy tym, że coraz więcej badań sugeruje jednocześnie, że nadmiarowe blokady nie zawsze wynikają z przypadkowych błędów popełnianych przez moderatorów platform czy niedoskonałości automatycznych narzędzi oceny treści. Wykazano bowiem, że systemowo uderzają one częściej w niektóre grupy społeczne, rasowe czy mniejszości seksualne, prawdopodobnie w wyniku tzw. skrzywienia wykorzystywanych w procesie moderacji algorytmów[41].

Drugim narzędziem mogącym wpływać na dostępność i zasięg materiałów publikowanych przez media są wspomniane wcześniej systemy rekomendacyjne, które na największych platformach nie sprzyjają szerokiej dystrybucji „jakościowych” treści. Jak piszą E. Bell i in., w aktualnym modelu funkcjonowania największych platform internetowych „wartościowe, zaangażowane społecznie dziennikarstwo, które ujawnia nadużycia władzy, służy lokalnym i defaworyzowanym społecznościom, jest dyskryminowane przez system, w którym liczy się liczba kliknięć i udostępnień”[42]. Przykład takiej sytuacji podaje Z. Tufekci, wykazując, że informacje publikowane nt. „Ice Bucket Challenge”[43] zyskały dużo większą ekspozycję na platformie Facebook niż publikowane z tym samym czasie informacje nt. protestów wywołanych zastrzeleniem czarnoskórego nastolatka przez policjanta w 2014 r. w Ferguson[44]. Badanie L. Edelson i D. McCoya wskazuje natomiast, że w okresie od sierpnia 2020 r. do stycznia 2021 r. strony internetowe znane z publikowania dezinformacji miały sześciokrotnie większą liczbę udostępnień, „polubień” i innych interakcji na platformie Facebook niż wiarygodne źródła wiadomości, takie jak uznane media (np. CNN) czy Światowa Organizacja Zdrowia[45].

Zagrożeniem dla mediów jest jednak nie tylko model biznesowy premiujący „klikalność”, ale także brak przejrzystości. Wspomina o tym m.in. I. Wolska-Zogata, zwracając uwagę, że „[k]ontrowersje wzbudza fakt, że choć wydawcy mogą swobodnie publikować na Facebooku, to tajemniczy algorytm decyduje, co dociera do czytelnika”[46]. Dostępność publikacji dziennikarskich w internecie jest więc w praktyce w dużej mierze uzależniona od nieprzewidywalnych i często nietransparentnych decyzji właścicieli największych platform cyfrowych, którzy mogą swobodnie wpływać na ich większą bądź mniejszą ekspozycję, m.in. modyfikując parametry algorytmów sortowania i kierowania treści. Jednocześnie użytkownicy platform, zarówno ci, którzy korzystają z nich, aby szerzej docierać z własnymi treściami, jak i ci, który wykorzystują je głównie jako kanał dostępu do informacji, najczęściej nie otrzymują od pośredników przejrzystych informacji o zasadach funkcjonowania systemów rekomendacyjnych, ani tym bardziej możliwości zmiany logiki ich działania.

Obserwacje prowadzone w ostatnich latach sugerują, że wprowadzane przez największe platformy zmiany w zasadach działania algorytmów rekomendujących treści nie są korzystne dla sektora medialnego[47] i często uderzają bezpośrednio w jego interesy ekonomiczne. Gdy w styczniu 2018 r. Facebook zmodyfikował swój system rekomendacyjny, kładąc większy nacisk na promowanie „interakcji pomiędzy znajomymi i rodziną”, kosztem treści pochodzących m.in. od profesjonalnych mediów, według szacunków niektórych organizacji zrzeszających wydawców, skutkowało to obniżeniem liczby odwiedzających należące do nich witryny wahającym się od niemal 30[48] do 50 procent[49].

Meta (właściciel Facebooka) odpiera zarzuty badaczy i wydawców, przekonując, że wprowadzenie przez firmę zmiany w algorytmie rekomendacyjnym nie wpływają negatywnie na zasięg rzetelnych treści dziennikarskich[50], a ponadto wydawcy mogą korzystać z innych rozwiązań, które oferuje platforma, aby ułatwić mediom promocję własnych materiałów[51]. Przykładowo, na fali walki z dezinformacją w 2017 r. Facebook zmodyfikował swój algorytm w taki sposób, aby faworyzował „autentyczne treści”, wprowadzał także różne „etykiety” sugerujące, że mamy do czynienia z nierzetelną publikacją (np. „kwestionowane wiadomości” czy „fałszywa informacja”), ograniczając jednocześnie widoczność tych materiałów i możliwość ich udostępniania. Z jednej strony stwarza to realną szansę dla lepszej ekspozycji jakościowego dziennikarstwa kosztem nierzetelnych informacji. Z drugiej strony, proces oceny i przyznawania „etykiet” budzi podobne zastrzeżenia jak w przypadku usuwania treści w zakresie braku przejrzystości i arbitralności, co rodzi ryzyko nałożenia nieuzasadnionych ograniczeń i podważenia wiarygodności błędnie oznaczonych publikacji. Poza tym badacze wykazali, że beneficjentami tak zoptymalizowanego systemy rekomendacyjnego są jedynie niektóre media[52].

DSA i DMA – szansa dla mediów na uniezależnienie od wielkich platform?

Czy nowy pakiet regulacyjny wzmocni pozycję profesjonalnych mediów względem wielkich platform i pozwoli im się wreszcie wyrwać z cyfrowego klinczu? Media, podobnie jak inni użytkownicy, staną się niewątpliwie beneficjentami wszystkich tych postanowień DSA i DMA, które zwiększają np. gwarancje przejrzystości moderacji treści, systemów rekomendacyjnych czy ochronę interesów mniejszych usługodawców. Ale rewolucji raczej nie będzie.

W DSA pozycję mediów wobec cybergigantów może wzmocnić obowiązek zapewnienia standardów sprawiedliwości proceduralnej w obszarze moderacji treści, zakładających większą transparentność podejmowanych decyzji oraz możliwość skutecznego odwołania się od nich, w tym do niezależnego organu (pozasądowego ciała rozpoznawania sporów lub sądu). Rozwiązania te sprawią, że również wydawcy będą mogli skuteczniej kwestionować niesłuszne (ich zdaniem) decyzje platform o usunięciu bądź ograniczeniu widoczności pochodzących od nich treści. To duży krok naprzód, ponieważ dziś możliwości dochodzenia przywrócenia usuniętych treści są w praktyce trudnodostępne. Dowodzi tego choćby skomplikowane – trwające już od kilku lat precedensowe postępowanie sądowe – w którym Fundacja Panoptykon wspiera organizację Społeczna Inicjatywa Narkopolityki, zablokowaną przez Facebooka z niejasnych przyczyn w 2018 r.[53]. Ponadto bardziej realna możliwość rozliczenia platform z ich decyzji moderacyjnych oraz ograniczenia w stosowaniu przez nie algorytmów w tym procesie (np. odwołania od decyzji o usunięciu treści nie będą mogły być rozpoznawane przy udziale jedynie automatycznych narzędzi) może wymusić ogólną większą staranność po ich stronie i wpłynąć na zmniejszenie liczby błędnych decyzji.

Co ciekawe, w toku prac nad DSA pojawiła się koncepcja wprowadzenia do niego „przywileju dla mediów”, który wprost zakazywałby usuwania przez platformy treści dziennikarskich (bądź obwarowywał je dodatkowymi obostrzeniami). Ostatecznie jednak, taki „immunitet” dla mediów nie zyskał poparcia politycznego. Protestowały przeciw niemu m.in. organizacje walczące z dezinformacją, argumentując, że z dużym prawdopodobieństwem wykorzystają go portale podszywające się pod profesjonalne media do jeszcze bardziej swobodnego rozsiewania fake newsów i dezinformacji[54]. Finalnie w rozporządzeniu znalazł się znacznie bardziej „miękki” nakaz uwzględniania przez usługodawców internetowych standardów z zakresu wolności słowa oraz wolności i pluralizmu mediów podczas tworzenia i stosowania wewnętrznych zasad dotyczących m.in. moderacji treści[55]. Nie gwarantuje to mediom absolutnej ochrony przed ingerencją platform w publikowane przez nie treści, ale mimo wszystko stawia je w nieco bardziej uprzywilejowanej pozycji w toku ewentualnych postępowań odwoławczych.

DSA nie rozwiązuje jednak przede wszystkim problemów wynikających z przeniesienia kontroli nad dystrybucją informacji na duże platformy, w tym zagrożenia „niewidzialnością” (ang. threat of invisibility[56]) publikacji medialnych, związanego z funkcjonowaniem wspomnianych wcześniej algorytmów personalizujących rekomendowane treści. Co prawda największe platformy będą musiały wykazać się większą przejrzystością – jak wspomniano wcześniej, użytkownik będzie mógł sprawdzić, jakie parametry mają wpływ na dobór treści, które wyświetla mu platforma, a także prawdopodobnie wybrać taki system ich rekomendowania, który nie będzie oparty na profilowaniu.

W praktyce jednak użytkownik będzie miał wciąż niewielki wpływ na wybór ww. parametrów, tj. na to, jakiego typu treści będą „promowane” (i z większym prawdopodobieństwem zyskają uwagę odbiorców), a jakie „defaworyzowane” (co często de facto eliminuje je z pola widzenia). Niestety propozycja, która mogła wymusić realną zmianę – tj. otwarcie rynku na alternatywne systemy rekomendacyjne oferowane przez zewnętrzne podmioty, działające według innej logiki niż ta promującą „klikalność za wszelką cenę” – nie zyskała aprobaty unijnych decydentów. Być może stało się tak z uwagi na brak jasnych odpowiedzi na pewne wyzwania, jakie niesie ze sobą ta idea[57], a być może przesądził łatwy do przewidzenia opór branży technologicznej[58]. Tymczasem, dzięki takiemu rozwiązaniu użytkownicy mogliby uzyskać możliwość wyboru np. systemu eksponującego wiarygodne informacje pochodzące z profesjonalnych mediów i rzetelne dziennikarstwo, co przyczyniłoby się do zwiększenia zasięgu tego rodzaju treści. Profesjonalne media skorzystałyby nie tylko na większej popularności swoich materiałów, ale mogłyby być zapewne także dostawcą takich alternatywnych systemów. Otworzyłoby to dla nich pole do zaoferowania nowej usługi, jednocześnie przywracając branży nieco większą kontrolę nad dystrybucją wiadomości w internecie.

Jeśli natomiast jedyną alternatywą, którą w rzeczywistości wymusi DSA w ramach obowiązku zapewnienia jednego systemu rekomendacyjnego nieopartego na profilowaniu, będzie wyłącznie możliwość wyboru np. chronologicznego układu strumienia aktualności, to choć jest to rozwiązanie sprzyjające większej ochronie prywatności, może być ono w praktyce całkowicie „niestrawne” z punktu widzenia użytkowników, którzy zasadnie oczekują pewnej „selekcji” informacji[59] (tyle że niekoniecznie według klucza, który dziś gwarantuje platformom największe zyski). Nie wpłynie to też raczej na większą widoczność informacji pochodzących z profesjonalnych mediów. Poza tym użytkownik będzie musiał taką opcję aktywnie wybrać, więc można się spodziewać, że większość osób i tak pozostanie przy domyślnych ustawieniach.

Jednocześnie pewnym narzędziem, które ma szansę doprowadzić do poprawy sytuacji mediów na wielkich platformach i w wielkich wyszukiwarkach są wspomniane obowiązkowe oceny systemowych ryzyk. Jak już wyjaśniono wyżej, w DSA wprost podkreślono, że oceny te muszą obejmować analizę negatywnego wpływu mechanizmów funkcjonowania platform na m.in. swobodę wypowiedzi, w tym wolność i pluralizm mediów. Z pewnością branża mediów będzie mogła wykorzystywać ten instrument do lepszego identyfikowania i przeciwdziałania ewentualnym nieprawidłowościom, takim jak np. „algorytmiczna dyskryminacja” jakościowych materiałów prasowych w systemach moderacyjnych czy rekomendacyjnych. Tym bardziej, że – przypomnijmy – oceny ryzyk będą podlegać nie tylko kontroli audytorów i organów regulacyjnych, ale do pewnego stopnia również kontroli społecznej, poprzez np. obowiązek udostępniania ich treści i danych na żądanie uwierzytelnionych badaczy (także mogących działać na rzecz organizacji dziennikarskich czy wydawców).

Nie zmienia to jednak faktu, że jeśli chodzi o regulację systemów rekomendacyjnych, DSA pozostawia pewien niedosyt. Można jedynie mieć nadzieję, że rozporządzenie stanie się punktem wyjścia do dyskusji o przyjęciu dalej idących rozwiązań w przyszłości.

Na ile natomiast DMA wzmocni pozycję profesjonalnych mediów względem strażników dostępu? Jak wspomniano, ten drugi filar reformy regulacji rynku cyfrowego ma chronić nie tylko konsumentów, ale też przedsiębiorców przed nieuczciwym traktowaniem ze strony wielkich firm technologicznych, z których usług korzystają do sprzedaży swoich produktów. Teoretycznie DMA ma więc pomóc też małym firmom i startupom, którym obecnie ciężko utrzymać się na rynku ze względu na silną konkurencję. Media są niewątpliwie jedną z branż, która w największym stopniu powinna skorzystać na powyższych założeniach. Jednak zdaniem organizacji zrzeszających wydawców zaproponowane w pierwotnym projekcie DMA rozwiązania były do tego daleko niewystarczające. Dlatego też sektor medialny domagał się w toku prac nad rozporządzeniem wprowadzenia szeregu poprawek wzmacniających ochronę jego interesów w cyberprzestrzeni[60]. Ostatecznie jednak tylko część z tych postulatów znalazła się w finalnej wersji DMA.

Jeden z głównych zarzutów środowiska wydawców dotyczył braku obowiązku zapewniania sprawiedliwych, niedyskryminujących warunków dostępu dla użytkowników biznesowych do wszystkich typów usług objętych rozporządzeniem, a nie tylko sklepów z aplikacjami (jak przewidywał projekt Komisji). Z punktu widzenia wydawców szczególnie ważna była gwarancja takiego dostępu do mediów społecznościowych i wyszukiwarek, które – jak wskazano wyżej – są głównymi kanałami dotarcia do publikowanych przez nie wiadomości. W tym zakresie wydawcy odnieśli sukces rzeczniczy – DMA obliguje cybergigantów do zapewnienia sprawiedliwego dostępu do wszystkich trzech typów usług.

Z zadowoleniem przyjęto również takie propozycje, jak np. zakaz preferencyjnego traktowania własnych produktów przez dominujące platformy (co oznacza np. zakaz umieszczania przez strażników dostępu własnych produktów lub usług wyżej na liście wyników wyszukiwania w porównaniu z produktami lub usługami innych firm). Wydawcy zwracali jednak jednocześnie uwagę, że ta restrykcja powinna zostać rozszerzona także na preferencyjne traktowanie wybranych usług zewnętrznych. Tak, aby np. wyszukiwarka Google czy system rekomendacyjny Facebooka nie zapewniały większej widoczności wybranym przez siebie mediom o określonej linii redakcyjnej, kosztem mniej „wygodnej” konkurencji. W tym kontekście warto przypomnieć, że w 2016 r. Facebookowi zarzucono na przykład, że promuje materiały prasowe reprezentujące poglądy liberalne, ograniczając przy tym zasięg mediów o konserwatywnym, prawicowym zabarwieniu[61]. Mimo tych argumentów wyraźny zakaz preferencyjnego traktowania wybranych usług zewnętrznych nie znalazł się w DMA.

Sektorowi medialnemu zależało ponadto na zagwarantowaniu w DMA „prawa do zapłaty uczciwego wynagrodzenia” dostawcom treści przez największe platformy, m.in. za wykorzystanie materiałów dziennikarskich, w tym wprowadzenie obowiązku uczestniczenia przez strażników dostępu w wiążących procedurach ustalania uczciwej ceny za m.in. licencjonowanie praw wydawców[62]. Ich zdaniem pozwoliłoby to na przynajmniej częściowe zrekompensowanie ponoszonych przez media wysokich wydatków na proces przygotowania publikacji dziennikarskich, które następnie są eksploatowane przez platformy dla ich własnego zysku, bez konieczności ponoszenia tego rodzaju obciążeń oraz odpowiedzialności za treści w tym samym zakresie, co sektor medialny. Rozwiązanie to także nie przebiło się jednak do finalnego tekstu rozporządzenia.

Wreszcie branża medialna domagała się również większego wyrównania szans w obszarze reklamy w sieci. DMA niewątpliwie wymusza większą przejrzystość po stronie strażników dostępu i zwiększa możliwości wydawców w zakresie rozliczania ich z efektywności świadczonych usług reklamowych. Wbrew żądaniom branży medialnej w DMA nie wprowadzono jednak zakazu, aby w aukcjach reklam, które prowadzą strażnicy dostępu w ramach świadczenia usług pośrednictwa reklamowego, nie mogły brać udziału powiązane z nimi podmioty. Stało się tak, pomimo argumentacji wydawców, że podmioty takie mogą mieć dostęp do danych, które mogłyby zapewnić im uprzywilejowaną pozycję i wyższe miejsce w rankingu reklam, a finalnie lepszą ekspozycję pochodzących od nich komunikatów. Wydawcom nie udało się również przeforsować zakazu „faworyzowania” widoczności reklam, kosztem bezpłatnych treści odpowiadających kryterium trafności. Chodziło o to, żeby wyeliminować m.in. praktykę stałego przydzielania najwyższych pozycji w wynikach wyszukiwania płatnym komunikatom oraz narzucić wyraźne ograniczenia dla przestrzeni, którą strażnicy dostępu mogą przeznaczyć na wyświetlanie reklam.

W efekcie wszystkie powyższe „braki” stawiają pod znakiem zapytania nadzieję, że nowa regulacja wystarczy do tego, aby realnie i znacząco ograniczyć władzę oraz dominację cyfrowych strażników dostępu.

Podsumowanie

Dyrektywa o handlu elektronicznym przetrwała ponad 20 lat. Pakiet regulacyjny DSA-DMA ma potencjał, aby ustalić warunki nowego ładu cyfrowego na kolejne dwie czy trzy dekady. Z punktu widzenia branży medialnej, która w sieci występuje nie tylko w roli dostawców treści, ale także pośredników (np. hostingodawców w stosunku do sekcji komentarzy), ważne są oczywiście wszystkie wiążące ją nowe postanowienia w zakresie m.in. moderacji treści.

DSA doprecyzowuje wiele kwestii w tej sferze, które dotychczas budziły istotne problemy interpretacyjne, powodując niepewność prawną po stronie wydawców (choć część wątpliwości pozostała nierozstrzygnięta). Zachowane zostały przy tym korzystne dla usługodawców założenia, takie jak warunkowe wyłączenie odpowiedzialności za treści dodane przez osoby trzecie czy zakaz ogólnego obowiązku monitoringu takich publikacji. Jednocześnie nowa regulacja oznacza też nowe obowiązki związane z moderacją, które sektor medialny będzie musiał wdrożyć wraz z jej wejściem w życie.

Dla losów całej branży mediów najbardziej kluczowe wydają się jednak postanowienia DSA-DMA odnoszące się nie tyle do nich samych, ile do największych platform internetowych i wyszukiwarek. Rosnące znaczenie platform w komunikacji internetowej, w tym dla dostępu do newsów, stało się nie tylko źródłem nowych wyzwań prawnych w wielu obszarach związanych z obiegiem informacji w sieci, ale także napięć pomiędzy sektorem big tech a „tradycyjnymi” mediami. Dynamiczny rozwój najważniejszych cyberkorporacji z jednej strony doprowadził do podkopania fundamentów ekonomicznych sektora medialnego, a z drugiej strony w dużym stopniu odebrał mu kontrolę nad dystrybucją własnych treści.

Pakiet DSA-DMA niewątpliwie w jakimś stopniu wzmocni pozycję mediów w tym układzie, wyposażając je w szereg nowych uprawnień i gwarancji ochronnych, z których będą mogły korzystać, aby kwestionować władzę technologicznych gigantów. W większości są to jednak te same zasady ograniczające arbitralność działania największych platform, z których będą mogli korzystać inni użytkownicy indywidualni czy biznesowi, w tym raczej „miękkie” gwarancje wolności słowa i wolności mediów. Branży medialnej nie udało się natomiast przeforsować szczególnie istotnych z punktu widzenia interesu wydawców „przywileju dla mediów” w DSA oraz „prawa do zapłaty uczciwego wynagrodzenia” w DMA. To zapewne dwie najpoważniejsze porażki rzecznicze tego sektora.

Z pewnością szczególnie pozytywny wpływ na media będą miały rozwiązania gwarantujące większą przejrzystość różnych aspektów funkcjonowania wielkich platform i wyszukiwarek, w tym algorytmów wpływających na ekosystem informacyjny, w którym poruszają się ich użytkownicy. Zabrakło jednak bardziej radykalnych rozwiązań, które zwiększyłyby realną szansę na zmianę najbardziej szkodliwych praktyk cyberkorporacji w tym zakresie. Brak otwarcia rynku na zewnętrznych dostawców systemów rekomendacyjnych, promujących np. rzetelne, zróżnicowane dziennikarskie treści oraz brak zagwarantowania większego wpływu użytkowników na logikę działania algorytmów samych platform, oznacza, że w praktyce zachowają one znaczącą moc kształtowania doświadczeń cyfrowych i poglądów dużej części opinii publicznej. Zgubne skutki takiego status quo widać w dobie współczesnych kryzysów, w szczególności pandemii i wojny, gdzie zjawiska takie jak dezinformacja, której zasięgi wzmacnia obecny model działania dominujących mediów społecznościowych czy wyszukiwarek, urosły do rangi kwestii życia i śmierci.

Podsumowując, od dawna podkreśla się, że w dłuższej perspektywie warunkiem przetrwania „jakościowego” dziennikarstwa jest uniezależnienie od eksploatującej relacji z cybergigantami. Pakiet DSA-DMA to ważny krok w tę stronę, ale tak długo jak media pozostaną „na łasce” algorytmów wielkich platform i wyszukiwarek, trudno będzie im odzyskać utracone na ich rzecz wpływy.

[1] Dyrektywa 2000/31/WE Parlamentu Europejskiego i Rady z dnia 8 czerwca 2000 r. w sprawie niektórych aspektów prawnych usług społeczeństwa informacyjnego, w szczególności handlu elektronicznego w ramach rynku wewnętrznego (dyrektywa o handlu elektronicznym). Postanowienia dyrektywy zostały wdrożone do polskiego prawa na mocy przyjętej w 2002 r. Ustawy o świadczeniu usług drogą elektroniczną.

[2] Zob. np. raport Specjalnego Sprawozdawcy ONZ ds. promocji oraz ochrony prawa do wolności wyrażania opinii oraz wolności wypowiedzi, nr A.HRC.17.27, w którym podkreślono, że „sposób, w jaki dziś przekazuje się informacje, zależy w dużej mierze od prywatnych firm, które dostarczają odpowiednie usługi umożliwiające komunikację internetową i zawieranie umów pomiędzy jednostkami”; natomiast zgodnie z Rekomendacją Komitetu Ministrów Rady Europy dotyczącą wartości społecznej Internetu Nr (Rec 2007) 16, „korzystanie z serwisów społecznościowych stwarza aktualnie najbardziej dogodną możliwość aktywnego udziału obywateli w demokracji”.

[3] Zob. np. wyroki Europejskiego Trybunału Praw Człowieka ws. Delfi p. Estonii (par. 110) czy Cengiz i inni p. Turcji (par. 52) czy wyrok Trybunału Sprawiedliwości Unii Europejskiej ws. Google Spain SL, Google Inc. przeciwko Agencia Española de Protección de Datos (AEPD), Mario Costeja González (par. 36–38).

[4] D. Abul-Fottouh, M.Y. Song, A. Gruzd, Examining algorithmic biases in YouTube’s recommendations of vaccine videos, „International Journal of Medical Informatics” t. 140 (2020), E. Llansó i in., Artificial Intelligence, Content Moderation, and Freedom of Expression, (2020); L. Munn, Angry by design: toxic communication and technical architectures, „Humanities and Social Sciences Communications” t. 7 nr 1 (2020), F. Saurwein, C. Spencer-Smith, Automated Trouble: The Role of Algorithmic Selection in Harms on Social Media Platforms, „Media and Communication” t. 9 nr 4 (2021), J. McCrosky, B. Geurkink, YouTube Regrets, Mozilla Foundation, 2021; W. Oremus, Why Facebook won’t let you control your own news feed, Washington Post”, 13 listopada 2021 r.

[5] S. Zuboff, The age of surveillance capitalism: The fight for a human future at the new frontier of power, Nowy Jork, 2019. Zob. także: Ranking Digital Rights, It’s the Business Model: How Big Tech’s Profit Machine is Distorting the Public Sphere and Threatening Democracy, 2020.

[6] Zob. Kodeks postępowania w zakresie zwalczania nielegalnego nawoływania do nienawiści w Internecie z 2016 r. oraz Kodeks postępowania w zakresie zwalczania dezinformacji z 2018 r., które z inicjatywy Komisji Europejskiej podpisały duże firmy internetowe. Komisja publikuje cykliczne sprawozdania z realizacji postanowień kodeksów.

[7] Np. w Niemczech (tzw. NetzDG) czy Francji (tzw. ustawa anty-separatystyczna).

[8] Zob. np. ogłoszony w 2021 r. przez Ministerstwo Sprawiedliwości projekt Ustawy o ochronie wolności słowa w internetowych serwisach społecznościowych.

[9] W chwili przygotowywania niniejszego tekstu (lipiec 2022 r.) instytucje UE zakończyły negocjacje nad ostatecznym tekstem obu rozporządzeń (tzw. trilog). Zostały one też przyjęte przez Parlament Europejski i oczekują na ostateczną akceptację Rady UE. Z dużym prawdopodobieństwem jest to jednak już tylko formalność. W praktyce trilog jest zazwyczaj ostatnim znaczącym etap negocjacji pomiędzy instytucjami UE. W przypadku ok. 96% regulacji są one potem formalnie uchwalane bez zmian na posiedzeniach plenarnych Parlamentu i Rady. Zob. A. Kirpsza, Nie chcę, ale muszę” : powody negocjowania aktów prawnych Unii Europejskiej w trilogach [w] K. A. Wojtaszczyk, J. Wiśniewska-Grzelak (red.), Teorie i metody w studiach europejskich : V Ogólnopolskie Europeistyczne Warsztaty Metodologiczne dla Doktorantów i Habilitantów, Warszawa 2015.

[10] DSA dotyczy trzech rodzajów usług pośrednich: zwykłego przekazu (mere conduit), cachingu i hostingu.

[11] Najwcześniej, bo najprawdopodobniej już na początku 2023 r., zaczną obowiązywać przepisy DSA dotyczące wielkich platform. Większość przepisów DMA, w tym nakazy i zakazy dla cybergigantów, wejdzie w życie najpewniej w pierwszym kwartale 2023 r. Przepisy DSA dotyczące „zwykłych” platform, hostingodawców oraz innych pośredników internetowych zaczną obowiązywać prawdopodobnie dopiero w pierwszym kwartale 2024 r. Dokładne daty zależą m.in. od formalnego zakończenia procesu legislacyjnego (zob. przypis wyżej).

[12] Rozporządzenie Parlamentu Europejskiego i Rady w sprawie jednolitego rynku usług cyfrowych (akt o usługach cyfrowych) i zmieniające dyrektywę 2000/31/WE, tekst przyjęty przez Parlament Europejski 5 lipca 2022 r.

[13] W tym zakresie DSA zastąpi postanowienia ww. dyrektywy o handlu elektronicznym.

[14] Zgodnie z art. 2 lit. h „platformy internetowe” stanowią w DSA węższą kategorię dostawców usług hostingowych, którzy na żądanie usługobiorcy usługi, przechowują i rozpowszechniania publicznie informacje, chyba, że taka działalność ma charakter jedynie „nieznaczny i poboczny w stosunku do innej usługi i z przyczyn obiektywnych i technicznych nie może być wykorzystywana bez tej innej usługi, a integracja funkcji z inną usługą nie jest sposobem na obejść zastosowanie niniejszego rozporządzenia.”. Obejmują m.in. portale społecznościowe (np. Facebook, Instagram, YouTube), platformy sprzedażowe (np. Allegro, OLX), platformy noclegowe (np. Booking, Airbnb), platformy wymiany treści (np. Twitter) czy sklepy z aplikacjami (np. Google Play). Niektóre z ww. platform będą kwalifikowały się do kategorii „wielkich platform internetowych- VLOPs”.

[15] Platformy VOD takie, jak Netflix czy Amazon Prime podlegają obowiązkom Dyrektywy o audiowizualnych usługach medialnych (AVMS) i ponoszą odpowiedzialności redakcyjną za opublikowane na nich materiały. DSA nie obejmuje też platform opartych na modelu gig economy, takich jak np. Uber.

[16] Dotyczy to mikro i małych przedsiębiorców w rozumieniu Aneksu do Rekomendacji 2003/361/EC.

[17] Zgodnie z treścią motywu 13 „sekcja komentarzy” ma w tym przypadku jedynie poboczny charakter w stosunku do innej, głównej usługi, tj. publikowania materiałów pochodzących od redakcji, i w związku z tym nie spełnia kryteriów określonych art. 2 lit. h (zob. przypis nr 15).

[18] DSA nie wprowadza szczególnego katalogu bezprawnych treści, a jedynie horyzontalne ramy mające zastosowanie do wszelkich rodzajów bezprawnych treści, usług, czy produktów, które są bezprawne w świetle prawa UE lub według prawa krajowego państw członkowskich (z zastrzeżeniem szczególnych przepisów prawa UE, które stosują się do niektórych rodzajów bezprawnych treści np. na mocy dyrektywy o prawach autorskich na jednolitym rynku cyfrowym, skupiającej się na walce z naruszeniami praw autorskich czy rozporządzenia ws. zapobiegania rozpowszechnianiu w Internecie treści o charakterze terrorystycznym). Postanowienia DSA w zakresie odpowiedzialności za treści nie odnoszą się natomiast do różnych typów szkodliwych, ale legalnych materiałów (np. niektórych form dezinformacji).

[19] Obowiązek sprawozdawczy nie dotyczy jednak najmniejszych usługodawców, tj. mikro i małych przedsiębiorców w rozumieniu Aneksu do Rekomendacji 2003/361/EC.

[20] Obowiązek reakcji platformy jest uzależniony od posiadania przez nią „pozytywnej wiedzy” o bezprawnym charakterze treści. Nie jest jednak dziś jasne, kiedy dokładnie platforma taką wiedzę nabywa (czy wystarczy, że filtruje automatycznie wszystkie treści albo poddaje je ocenie moderatorów przed publikacją?). Kolejny problem interpretacyjny dotyczy zakresu zakazu ogólnego obowiązku monitorowania treści użytkowników i działań służących przeciwdziałaniu nielegalnym materiałom, których należy oczekiwać od platform. Czy można wymagać, aby stosowały algorytmy służące do identyfikacji bezprawnych treści? W jakich sytuacjach i pod jakimi warunkami? Kiedy taki wymóg będzie nieproporcjonalny? Czy treści te powinny być automatycznie usuwane?

[21] Np. Trybunał Sprawiedliwości Unii Europejskiej w wyroku Sabam v. Scarlet (C-70/10) uznał, że zobowiązanie platformy do filtrowania wszelkich przesyłanych na nią treści byłoby nieproporcjonalne. Tymczasem standardy wypracowane dotychczas przez Europejski Trybunał Praw Człowieka m.in. ws. Delfi p. Estonii wskazują, że można wymagać tego rodzaju monitoringu od administratora strony (wydawcy portalu informacyjnego) w odniesieniu do materiałów zamieszczanych przez internautów stanowiących mowę nienawiści lub nawoływanie do przemocy (najbardziej skrajne nadużycia wolności słowa). W praktyce problematyczne pozostaje wprowadzenie wymogu stałego monitorowania treści stanowiących mowę nienawiści, bez narzucenia generalnego obowiązku kontrolowania wszelkich materiałów zamieszczonych przez użytkowników na portalu, co z kolei rodzi wątpliwości co do proporcjonalności tego ostatniego środka.

[22] Np. czy możemy mówić o tym, że hostingodawca ma „pozytywną wiedzę” o bezprawnym charakterze treści, jeśli zawiadomienie złożone w trybie procedury notice & action będzie zawierało przekonujące uzasadnienie, ale nie spełni wszystkich kryteriów formalnych wymienionych w art. 14 ust. 2 DSA? Albo gdy odpowiednie organy krajowe zwrócą się do hostingodawcy z wnioskiem o dostęp do danych w trybie art. 9 DSA odnośnie do konkretnych treści opublikowanych w jego serwisie? DSA nie daje na te pytania jasnych odpowiedzi. Zob. M. Cappello (red.), Unravelling the Digital Services Act package, IRIS Special, European Audiovisual Observatory, 2021, str. 13-15.

[23] Zob. np. A Obem, D. Głowacka, Algorytmy traumy. Sprawdziliśmy, czy możesz kontrolować reklamy na Facebooku, Fundacja Panoptykon, 28 września 2021 r.

[24] Warto wspomnieć w tym kontekście, że według raportu Corporate Europe Observatory, w sumie 612 firm lobbuje w dziedzinie rynku cyfrowego Unii Europejskiej i łącznie wydaje prawie 100 mln euro rocznie na ten cel. Znaczącą część tego stanowią budżety firm należących do grupy Big Tech. Aż 75 proc. lobbingu w instytucjach unijnych ma charakter biznesowy, a pod względem zaangażowania przewodziły firmy Google i Facebook, o łącznym rocznym budżecie ponad 11 mln euro. Zob. J. Krystek, Klęska lobby Big Tech? Akt o rynkach cyfrowych przegłosowany w Parlamencie Europejskim, 16 grudnia 2021 r.

[25] Global Witness, Amnesty International, France/Germany: Small businesses want EU to get tough on Google and Facebook’s invasive advertising – new research, 2022.

[26] W 2016 r. dziennik The Guardian sprawdził, ile środków z wydanych na wyświetlane na jego stronach reklamy śledzące trafia do pośredników, a ile do niego samego. Okazało się, że z każdego wydanego na reklamę funta jako wydawca otrzymał tylko 30 pensów. Inne badania wskazały, że do pośredników trafia od 35 do 70% kwot wydanych na reklamę. Według raportu Irish Council for Civil Liberties (ICCL) wydawcy z Holandii i Norwegii korzystający z reklamy kontekstowej odnotowali w ostatnim roku od 1,5 do prawie 4 razy więcej przychodów niż z reklamy śledzącej. Niewątpliwie regulacja reklamy internetowej jest jednym z zagadnień wzbudzających największe kontrowersje w trwających negocjacjach w UE. Zob. D. McCann, W. Stronge, P. Jones, Future of online advertising, 2021, The Greens, https://extranet.greens-efa.eu/public/media/file/1/7267; Irish Council for Civil Liberties, Sustainable without surveillance, 2021.

[27] Dane wywnioskowane (ang. inferred data) odnoszą się do danych, które platformy internetowe określają o użytkowniku na postawie obserwacji i analizy jego zachowania w sieci (np. czasu spędzanego na platformie czy historii przeglądanych lub „polubionych” stron). Zob. Europejska Rada Ochrony Danych, Wytyczne dotyczące targetowania użytkowników mediów społecznościowych, 8/2020, 2 września 2021 r.

[28] Rozporządzenie Parlamentu Europejskiego i Rady w sprawie kontestowalnych i uczciwych rynków w sektorze cyfrowym (akt o rynkach cyfrowych), tekst przyjęty przez Parlament Europejski 5 lipca 2022 r..

[29] W tym kontekście warto przypomnieć liczby, które nie pozostawiają wątpliwości co do ich dominacji w przestrzeni cyfrowej. Dla przykładu, Google posiada ponad 90 proc. udziału w światowym rynku wyszukiwarek internetowych, a udział serwisu „Facebook” na rynku mediów społecznościowych wynosi 2/3 (jest on dominującą tego rodzaju platformą w ponad 90 proc. Krajów). Zob. UNCTD, Digital Economy Report 2019, 2019.

[30] W pierwszych czterech latach obowiązywania DMA ta wymóg interoperacyjności obejmie jedynie wymianę wiadomości tekstowych, głosowych i plików, ale docelowo będzie rozszerzony na czaty grupowe oraz połączenia głosowe. Być może w przyszłości Komisja Europejska rozszerzy wymóg interoperacyjności także na inne usługi, np. portale społecznościowe

[31] E.J. Bell, T. Owen, The Platform Press: How Silicon Valley Reengineered Journalism, Tow Center for Digital Journalism, 2017, s. 14.

[32] N. Newman i in., Digital News Report 2020, Reuters Institute of Journalism, 2020, s. 23.

[33] Pew Research Center, Social media outpaces print newspapers in the U.S. as a news source, 2018.

[34] F. Bailo, J. Meese, E. Hurcombe, The Institutional Impacts of Algorithmic Distribution: Facebook and the Australian News Media, „Social Media + Society” t. 7 nr 2 (2021), s. 5.

[35] M. Ingram, The Facebook Armageddon, „Columbia Journalism Review” (2008).

[36] Badania wskazują, że od ok. 50-80 proc. odbiorców docierających do treści dziennikarskich za pośrednictwem mediów społecznościowych nie było w stanie odtworzyć nazwy gazety, która opublikowała źródłowy materiał (w przypadku wyszukiwarek internetowych odsetek ten wynosił ok. 40 proc.). Zob. E.J. Bell, T. Owen, The Platform Press…, s. 35; A. Kalogeropoulos, R. Fletcher, R.K. Nielsen, News brand attribution in distributed environments: Do people know where they get their news?, „New Media & Society” t. 21 nr 3 (2019), s. 10.

[37] E.J. Bell, T. Owen, The Platform Press…, s. 40–42.

[38] I. Wolska-Zogata, Prasa informacyjna w ekosystemie nowych mediów, „Media – Kultura – Komunikacja Społeczna” t. 3 nr 14 (2018), s. 35.

[39] M. Sweney, Facebook apologises for blocking Viz magazine’s page, „The Guardian” (2016).

[40] E.B. Union (EBU), Protecting Media Content Online: A Decisive Moment, 29 października 2021 r., dostęp 11 grudnia 2021 r.

[41] E. Llansó, J. van Hoboken, P. Leerssen, J. Harambam, Artificial Intelligence, Content Moderation, and Freedom of Expression, Transatlantic Working Group on Content Moderation Online and Freedom of Expression, 2020, str. 9.

[42] E.J. Bell, T. Owen, The Platform Press…, s. 10.

[43] Była to popularna w mediach społecznościowych akcja. Polegała na wylewaniu wiadra wody z lodem na głowę. Akcja miała rozpowszechnić świadomość na temat stwardnienia zanikowego bocznego oraz pomóc zebrać fundusze na badania nad tą chorobą.

[44] Z. Tufekci, Algorithmic harms beyond Facebook and Google: Emergent challenges of computational agency, „Colorado Technology Law Journal” t. 13 nr 203 (2015), s. 213–215.

[45] New York University Tandon School of Engineering, Misinformation on Facebook got six times more clicks than factual news during the 2020 election, study says, 3 września 2021 r.

[46] I. Wolska-Zogata, Prasa informacyjna w ekosystemie nowych mediów…, s. 35.

[47] Według badania F. Bailo et al. w 2020 r. wskaźniki zaagnażowania na Facebooku były dla australijskich mediów znacząco niższe niż w 2014 r. (poziom „polubień” i innych reakcji spadł o 42 proc., komentarzy o 64 proc., a udostępnień o 15 proc.). Autorzy wskazują jednak, że trend ten nie dotyczył australijskich mediów publicznych, w przypadku których odnotowano wzrost wskaźników zaangażowania. Było to prawdopodobnie związane z wysokim poziomem zaufania, jakim media te cieszą się w Australii, co znalazło odbicie w wysokiej pozycji w systemie rekomendacyjnym, który – jak twierdzi platforma – od 2018 r. w większym stopniu promuje „zaufane źródła”. F. Bailo, J. Meese, E. Hurcombe, The Institutional Impacts of Algorithmic Distribution…, s. 9,11; E.J. Bell, T. Owen, The Platform Press…, s. 63.

[48]C. Arendt, Facebook’s biggest losers: Content hurt by the last product strategy update, „Parse.ly”, 7 marca 2019 r.

[49] J. Duke, Facebook’s algorithm changes cut publishers’ traffic in half [na:] „The Sydney Morning Herald”, https://www.smh.com.au/business/companies/facebook-s-algorithm-changes-cut-publishers-traffic-in-half-20180503-p4zd3e.html, 3 maja 2018 r., dostęp 22 grudnia 2021 r.

[50] Meta, Prioritizing Original News Reporting on Facebook, 2020.

[51] Meta, How Facebook News Feed works for publishers.

[52] Jak wspomniano wyżej, w australijskim badaniu były nimi media publiczne, co badacze wiązali z wysokim poziomem zaufania, jakim cieszą się one w społeczeństwie F. Bailo, J. Meese, E. Hurcombe, The Institutional Impacts of Algorithmic Distribution…, s. 9.

[53] Więcej o szczegółach sprawy można przeczytać na stronie: https://panoptykon.org/sinvsfacebook.

[54] EU DisinfoLab, Fact-checkers and experts call on MEPS to reject a media exemption in the DSA, 2022.

[55] W głosowaniu plenarnym Parlament Europejski w styczniu 2022 r. odrzucił bardziej radykalne propozycje restrykcji dla możliwości moderowania materiałów pochodzących od mediów, ograniczając się do przyjęcia poprawki modyfikującej Art. 12 projektu Aktu o usługach cyfrowych w zakresie obowiązku poszanowania wolności słowa, wolności i pluralizmu mediów oraz gwarancji wynikających z obowiązujących regulacji prawa mediów w Europie.

[56] T. Bucher, Want to be on the top? Algorithmic power and the threat of invisibility on Facebook, „New Media & Society” t. 14 nr 7 (2012).

[57] D. Keller, The Future of Platform Power: Making Middleware Work, Journal of Democracy, t. 3 nr 32 (2021).

[58] Zob. np. materiały Stowarzyszenia Przemysłu Komputerowego i Komunikacyjnego (CCIA), międzynarodowej organizacji, która reprezentuje przemysł technologii informacyjnych i komunikacyjnych: V. De Posson, How The Digital Services Act Could Change What Europeans See Online, „Disruptive Competition Project”, 2021.

[59] C. O’Neil, A Chronoligical Feed Wouln’t Fix Racebook, Bloomberg, 18 listopada 2021 r.

Więź.pl to personalistyczne spojrzenie na wiarę, kulturę, społeczeństwo i politykę.

Cenisz naszą publicystykę? Potrzebujemy Twojego wsparcia, by kontynuować i rozwijać nasze działania.

Wesprzyj nas dobrowolną darowizną:

[60] Europejska Rada Wydawców, DMA: Summary of the European Publishers Council’s Priorities for Amendments to the Commission’s Proposal for a Regulation of the European Parliament and of the Council on contestable and fair markets in the digital sector (Digital Markets Act), 2021; Europejskie Stowarzyszenie Mediów Magazynowych (EMMA) i Europejskie Stowarzyszenie Wydawców Gazet (ENPA), Position paper on the Proposal for a regulation on contestable and fairmarkets in the digital sector – Digital Markets Act, 23 marca 2021; News Media Europe, Media sector calls for remaining loopholes in the Digital Markets Act to be addressed during trialogue, 25 listopada 2021 r.; News Media Europe, News publishers: “DSA and DMA are a missed opportunity to rebalance online ecosystem”, 20 grudnia 2020 r.

[61] N. Bowles, S. Thielman, Facebook accused of censoring conservatives, report says, The Guardian, 2016.

[62] L. Bertuzzi, Publishers’ last-minute attempt to secure ‘fair’ remuneration in the Digital Markets Act, Euractive, 24 March 2022.